Améliorations du modèle Tensorflow

Prise de notes sur les modèles de prédiction.

Augmentation du nombre d'unités LSTM

Utilisation de EarlyStopping

EarlyStopping est une technique qui arrête l'entraînement avant la fin des époques, si la performance sur les données de validation cesse de s'améliorer, ce qui permet de prévenir le surapprentissage et d'économiser du temps de calcul.

L'un des paramètres de l'EarlyStopping est la patience.

Il est inutile d'augmenter la patience pour arriver au bout des EPOCHS.

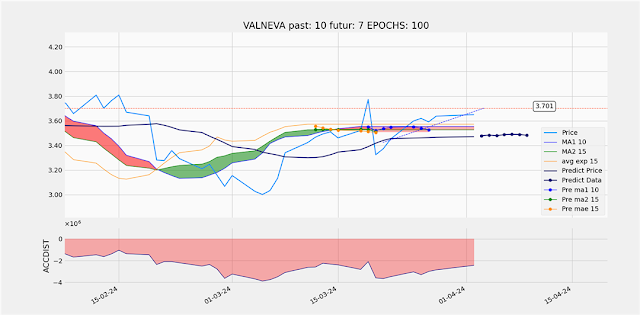

Démonstration :

|

| EarlyStopping patience = 18 |

En augmentant la patience :

|

| EarlyStopping patience = 32 |

Le nombre d'EPOCH augmente mais la prédiction n'est pas meilleure et le Score reste inchangé.

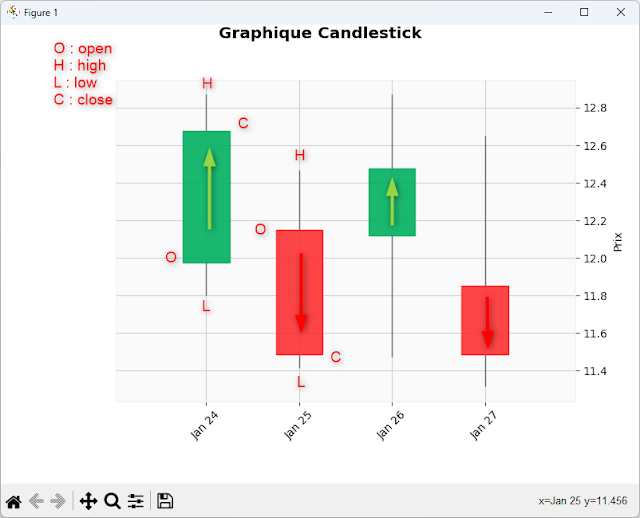

Dans l'algo 6 - TimeDistributed( Flatten() ) ou Reshape( (x_train.shape[1], -1) )

Amélioration de l'algo 6 en remplaçant la couche Flatten par un Reshape

|

| Flatten |

Reshape

|

| Reshape |

IL y a une meilleure imitation du signal avec Reshape qui au lieu de Flaten ne fait rien que de retailler le tenseur pour la couche suivante.

Augmentation du nombre de LSTM

Lorsque j'augmente le nombre d'unités LSTM j'augmente la capacité du modèle à apprendre les représentations complexes des données d'entrainement, l'erreur sur l'ensemble de validation cesse de diminuer.

Early Stopping qui surveille la perte sur l'ensemble de validation (val_loss), le modèle apprend plus vite et atteint un minimum de perte sur l'ensemble de validation plus tôt, ce qui déclenche l'early stopping après un nombre réduit d'epochs.

Commentaires

Enregistrer un commentaire